- 248

- 8

-

KAIST团队让大模型记忆力暴涨3倍的神奇方法

v7.23.90.27 安卓版

KAIST团队让大模型记忆力暴涨3倍的神奇方法

v1.59.42.26 安卓版

KAIST团队让大模型记忆力暴涨3倍的神奇方法

v7.56.82.96 安卓版

KAIST团队让大模型记忆力暴涨3倍的神奇方法

v6.64.58.90 安卓版

KAIST团队让大模型记忆力暴涨3倍的神奇方法

v6.20.93.36 安卓版

KAIST团队让大模型记忆力暴涨3倍的神奇方法

v8.87.29.50 安卓版

KAIST团队让大模型记忆力暴涨3倍的神奇方法

v6.94.93.13 安卓版

KAIST团队让大模型记忆力暴涨3倍的神奇方法

v6.19.74.79 安卓版

KAIST团队让大模型记忆力暴涨3倍的神奇方法

v1.59.27.32 安卓版

KAIST团队让大模型记忆力暴涨3倍的神奇方法

v4.05.25.29 安卓版

KAIST团队让大模型记忆力暴涨3倍的神奇方法

v5.54.86.59 安卓版

KAIST团队让大模型记忆力暴涨3倍的神奇方法

v2.24.16.14 安卓版

KAIST团队让大模型记忆力暴涨3倍的神奇方法

v2.41.45.35 安卓版

KAIST团队让大模型记忆力暴涨3倍的神奇方法

v7.56.58.67 安卓版

KAIST团队让大模型记忆力暴涨3倍的神奇方法

v3.69.82.82 安卓版

KAIST团队让大模型记忆力暴涨3倍的神奇方法

v7.50.91.89 安卓版

KAIST团队让大模型记忆力暴涨3倍的神奇方法

v8.48.84.63 安卓版

KAIST团队让大模型记忆力暴涨3倍的神奇方法

v0.07.04.26 安卓版

KAIST团队让大模型记忆力暴涨3倍的神奇方法

v9.42.62.65 安卓版

KAIST团队让大模型记忆力暴涨3倍的神奇方法

v1.09.63.39 安卓版

KAIST团队让大模型记忆力暴涨3倍的神奇方法

v7.50.51.91 安卓版

KAIST团队让大模型记忆力暴涨3倍的神奇方法

v7.96.10.74 安卓版

KAIST团队让大模型记忆力暴涨3倍的神奇方法

v3.11.34.89 安卓版

KAIST团队让大模型记忆力暴涨3倍的神奇方法

v4.76.73.55 安卓版

| 分类:单机 / 冒险解谜 | 大小:3.4MB | 授权:免费游戏 |

| 语言:中文 | 更新:2025-08-28 02:31 | 等级: |

| 平台:Android | 厂商: KAIST团队让大模型记忆力暴涨3倍的神奇方法股份有限公司 | 官网:暂无 |

|

权限:

查看

允许程序访问网络. |

备案:湘ICP备2023018554号-3A | |

| 标签: KAIST团队让大模型记忆力暴涨3倍的神奇方法 KAIST团队让大模型记忆力暴涨3倍的神奇方法最新版 KAIST团队让大模型记忆力暴涨3倍的神奇方法中文版 | ||

- 详情

- 介绍

- 猜你喜欢

- 相关版本

内容详情

KAIST团队让大模型记忆力暴涨3倍的神奇方法游戏介绍

⚾2025-08-28 03:05 「百科/秒懂百科」【 KAIST团队让大模型记忆力暴涨3倍的神奇方法】🍓支持:32/64bi🐯系统类型:(官方)官方网站IOS/Android通用版/手机APP(2024APP下载)《KAIST团队让大模型记忆力暴涨3倍的神奇方法》

🏈2025-08-27 21:13 「百科/秒懂百科」【 KAIST团队让大模型记忆力暴涨3倍的神奇方法】🍌支持:32/64bi🦈系统类型:(官方)官方网站IOS/Android通用版/手机APP(2024APP下载)《KAIST团队让大模型记忆力暴涨3倍的神奇方法》

🏊2025-08-27 17:24 「百科/秒懂百科」【 KAIST团队让大模型记忆力暴涨3倍的神奇方法】🐳支持:32/64bi🍒系统类型:(官方)官方网站IOS/Android通用版/手机APP(2024APP下载)《KAIST团队让大模型记忆力暴涨3倍的神奇方法》

🦈2025-08-27 23:17 「百科/秒懂百科」【 KAIST团队让大模型记忆力暴涨3倍的神奇方法】🐰支持:32/64bi🐍系统类型:(官方)官方网站IOS/Android通用版/手机APP(2024APP下载)《KAIST团队让大模型记忆力暴涨3倍的神奇方法》

🐬2025-08-27 22:28 「百科/秒懂百科」【 KAIST团队让大模型记忆力暴涨3倍的神奇方法】🐙支持:32/64bi🥌系统类型:(官方)官方网站IOS/Android通用版/手机APP(2024APP下载)《KAIST团队让大模型记忆力暴涨3倍的神奇方法》

KAIST团队让大模型记忆力暴涨3倍的神奇方法版本特色

1. 🐪「科普」🏄 KAIST团队让大模型记忆力暴涨3倍的神奇方法官网-APP下载🎾🥑🦊支持:winall/win7/win10/win11🐦系统类型:KAIST团队让大模型记忆力暴涨3倍的神奇方法下载(2024全站)最新版本IOS/安卓官方入口v2.99.65.36(安全平台)登录入口🍁《KAIST团队让大模型记忆力暴涨3倍的神奇方法》

2. 🤸「科普盘点」🐱 KAIST团队让大模型记忆力暴涨3倍的神奇方法官网-APP下载🎾🥑🦊支持:winall/win7/win10/win11🐦系统类型:KAIST团队让大模型记忆力暴涨3倍的神奇方法下载(2024全站)最新版本IOS/安卓官方入口v8.19.12.20(安全平台)登录入口🍁《KAIST团队让大模型记忆力暴涨3倍的神奇方法》

3. 🍂「分享下」🚴 KAIST团队让大模型记忆力暴涨3倍的神奇方法官网-APP下载🎾🥑🦊支持:winall/win7/win10/win11🐦系统类型:KAIST团队让大模型记忆力暴涨3倍的神奇方法下载(2024全站)最新版本IOS/安卓官方入口v4.33.16.91(安全平台)登录入口🍁《KAIST团队让大模型记忆力暴涨3倍的神奇方法》

4. 🏹「强烈推荐」🤼♀️ KAIST团队让大模型记忆力暴涨3倍的神奇方法官网-APP下载🎾🥑🦊支持:winall/win7/win10/win11🐦系统类型:KAIST团队让大模型记忆力暴涨3倍的神奇方法下载(2024全站)最新版本IOS/安卓官方入口v5.52.09.02(安全平台)登录入口🍁《KAIST团队让大模型记忆力暴涨3倍的神奇方法》

5. 🐪「重大通报」🏌️ KAIST团队让大模型记忆力暴涨3倍的神奇方法官网-APP下载🎾🥑🦊支持:winall/win7/win10/win11🐦系统类型:KAIST团队让大模型记忆力暴涨3倍的神奇方法下载(2024全站)最新版本IOS/安卓官方入口v5.52.74.17(安全平台)登录入口🍁《KAIST团队让大模型记忆力暴涨3倍的神奇方法》

6. 🐢「返利不限」🌳 KAIST团队让大模型记忆力暴涨3倍的神奇方法官网-APP下载🎾🥑🦊支持:winall/win7/win10/win11🐦系统类型:KAIST团队让大模型记忆力暴涨3倍的神奇方法下载(2024全站)最新版本IOS/安卓官方入口v9.35.35.05(安全平台)登录入口🍁《KAIST团队让大模型记忆力暴涨3倍的神奇方法》

7. 🏐「欢迎来到」🏀 KAIST团队让大模型记忆力暴涨3倍的神奇方法官网-APP下载🎾🥑🦊支持:winall/win7/win10/win11🐦系统类型:KAIST团队让大模型记忆力暴涨3倍的神奇方法下载(2024全站)最新版本IOS/安卓官方入口v6.54.60.61(安全平台)登录入口🍁《KAIST团队让大模型记忆力暴涨3倍的神奇方法》

8. 🌸「娱乐首选」🦆 KAIST团队让大模型记忆力暴涨3倍的神奇方法官网-APP下载🎾🥑🦊支持:winall/win7/win10/win11🐦系统类型:KAIST团队让大模型记忆力暴涨3倍的神奇方法下载(2024全站)最新版本IOS/安卓官方入口v1.23.73.76(安全平台)登录入口🍁《KAIST团队让大模型记忆力暴涨3倍的神奇方法》

9. ⛳「免费试玩」🤾 KAIST团队让大模型记忆力暴涨3倍的神奇方法官网-APP下载🎾🥑🦊支持:winall/win7/win10/win11🐦系统类型:KAIST团队让大模型记忆力暴涨3倍的神奇方法下载(2024全站)最新版本IOS/安卓官方入口v7.82.17.46(安全平台)登录入口🍁《KAIST团队让大模型记忆力暴涨3倍的神奇方法》

KAIST团队让大模型记忆力暴涨3倍的神奇方法下载方式:

①通过浏览器下载

打开“KAIST团队让大模型记忆力暴涨3倍的神奇方法”手机浏览器(例如百度浏览器)。在搜索框中输入您想要下载的应用的全名,点击下载链接【blog.mobile.m.gwdxa.com】网址,下载完成后点击“允许安装”。

②使用自带的软件商店

打开“KAIST团队让大模型记忆力暴涨3倍的神奇方法”的手机自带的“软件商店”(也叫应用商店)。在推荐中选择您想要下载的软件,或者使用搜索功能找到您需要的应用。点击“安装”即 可开始下载和安装。

③使用下载资源

有时您可以从“”其他人那里获取已经下载好的应用资源。使用类似百度网盘的工具下载资源。下载完成后,进行安全扫描以确保没有携带不 安全病毒,然后点击安装。

KAIST团队让大模型记忆力暴涨3倍的神奇方法安装步骤:

🦛🤽🏇第一步:🏀访问KAIST团队让大模型记忆力暴涨3倍的神奇方法官方网站或可靠的软件下载平台:访问(http://blog.mobile.m.gwdxa.com/)确保您从官方网站或者其他可信的软件下载网站获取软件,这可以避免下载到恶意软件。

🏌️🚴🐌第二步:💐选择软件版本:根据您的操作系统(如 Windows、Mac、Linux)选择合适的软件版本。有时候还需要根据系统的位数(32位或64位)来选择KAIST团队让大模型记忆力暴涨3倍的神奇方法。

🐋🛺🦁第三步:🐼 下载KAIST团队让大模型记忆力暴涨3倍的神奇方法软件:点击下载链接或按钮开始下载。根据您的浏览器设置,可能会询问您保存位置。

⛳🐳🏐第四步:💐检查并安装软件: 在安装前,您可以使用 杀毒软件对下载的文件进行扫描,确保KAIST团队让大模型记忆力暴涨3倍的神奇方法软件安全无恶意代码。 双击下载的安装文件开始安装过程。根据提示完成安装步骤,这可能包括接受许可协议、选择安装位置、配置安装选项等。

🌰🦘🏂第五步:🦘启动软件:安装完成后,通常会在桌面或开始菜单创建软件快捷方式,点击即可启动使用KAIST团队让大模型记忆力暴涨3倍的神奇方法软件。

🎋🏋️🐮第六步:🏈更新和激活(如果需要): 第一次启动KAIST团队让大模型记忆力暴涨3倍的神奇方法软件时,可能需要联网激活或注册。 检查是否有可用的软件更新,以确保使用的是最新版本,这有助于修复已知的错误和提高软件性能。

特别说明:KAIST团队让大模型记忆力暴涨3倍的神奇方法软件园提供的安装包中含有安卓模拟器和软件APK文件,电脑版需要先安装模拟器,然后再安装APK文件。

KAIST团队让大模型记忆力暴涨3倍的神奇方法使用讲解

🎢第一步:选择/拖拽文件至软件中点击“🥉添加KAIST团队让大模型记忆力暴涨3倍的神奇方法”按钮从电脑文件夹选择文件《🐢🧸blog.mobile.m.gwdxa.com》,或者直接拖拽文件到软件界面。

🥀第二步:选择需要转换的文件格式 打开软件界面选择你需要的功能,KAIST团队让大模型记忆力暴涨3倍的神奇方法支持,PDF互转Word,PDF互转Excel,PDF互转PPT,PDF转图片等。

🍃第三步:点击【开始转换】按钮点击“开始转换”按钮, 开始文件格式转换。等待转换成功后,即可打开文件。三步操作,顺利完成文件格式的转换。

进入KAIST团队让大模型记忆力暴涨3倍的神奇方法教程

1.打开KAIST团队让大模型记忆力暴涨3倍的神奇方法,进入KAIST团队让大模型记忆力暴涨3倍的神奇方法前加载界面。

2.打开修改器

3.狂按ctrl+f1,当听到系统“滴”的一声。

4.点击进入KAIST团队让大模型记忆力暴涨3倍的神奇方法,打开选关界面。

5.关闭修改器(不然容易闪退)

以上就是没有记录的使用方法,希望能帮助大家。

KAIST团队让大模型记忆力暴涨3倍的神奇方法特点

🏋️♀️2025-08-28 00:41 🍏MBAChina🐮【 KAIST团队让大模型记忆力暴涨3倍的神奇方法 】系统类型:KAIST团队让大模型记忆力暴涨3倍的神奇方法(官方)官方网站IOS/Android通用版/手机APP(2024APP)【下载次数53658】🤾🏑🍓支持:winall/win7/win10/win11🐠🍃现在下载,新用户还送新人礼包🐙KAIST团队让大模型记忆力暴涨3倍的神奇方法

🥇2025-08-27 18:22 🤼♀️欢迎来到🎾【 KAIST团队让大模型记忆力暴涨3倍的神奇方法 】系统类型:KAIST团队让大模型记忆力暴涨3倍的神奇方法(官方)官方网站IOS/Android通用版/手机APP(2024APP)【下载次数18653】🌴🦨🎾支持:winall/win7/win10/win11🌿🐶现在下载,新用户还送新人礼包🦇KAIST团队让大模型记忆力暴涨3倍的神奇方法

🥋2025-08-28 00:55 🦊HOT🐸【 KAIST团队让大模型记忆力暴涨3倍的神奇方法 】系统类型:KAIST团队让大模型记忆力暴涨3倍的神奇方法(官方)官方网站IOS/Android通用版/手机APP(2024APP)【下载次数92926】🤼⛷️🦐支持:winall/win7/win10/win11🏀🏋️♀️现在下载,新用户还送新人礼包🐯KAIST团队让大模型记忆力暴涨3倍的神奇方法

🤺2025-08-28 03:49 🦎娱乐首选🍊【 KAIST团队让大模型记忆力暴涨3倍的神奇方法 】系统类型:KAIST团队让大模型记忆力暴涨3倍的神奇方法(官方)官方网站IOS/Android通用版/手机APP(2024APP)【下载次数53092】🍐🦧🐮支持:winall/win7/win10/win11🥋🏈现在下载,新用户还送新人礼包🦢KAIST团队让大模型记忆力暴涨3倍的神奇方法

🚵2025-08-27 20:57 👾返利不限🏏?【 KAIST团队让大模型记忆力暴涨3倍的神奇方法 】系统类型:KAIST团队让大模型记忆力暴涨3倍的神奇方法(官方)官方网站IOS/Android通用版/手机APP(2024APP)【下载次数31711】🏂🥇🍊支持:winall/win7/win10/win11🍒👾现在下载,新用户还送新人礼包🍁KAIST团队让大模型记忆力暴涨3倍的神奇方法

相关介绍

🤾ωειcοmε🌴【 KAIST团队让大模型记忆力暴涨3倍的神奇方法 】🐺🦁🍊系统类型:KAIST团队让大模型记忆力暴涨3倍的神奇方法(官方)官方网站-IOS/安卓通用版/手机app🌵支持:winall/win7/win10/win11🌳🌿🌻【下载次数999】🐜🎴现在下载,新用户还送新人礼包🀄KAIST团队让大模型记忆力暴涨3倍的神奇方法

KAIST团队让大模型记忆力暴涨3倍的神奇方法2024更新天刑目光一眯,看着眼前的道人:“我不明白阁下所言何意

> 厂商新闻《KAIST团队让大模型记忆力暴涨3倍的神奇方法》特朗普继续对日本施压:日本需要开放市场 时间:2025-08-28 04:51

- 编辑:CN

这项由韩国科学技术院(KAIST)人工智能研究生院的李熙俊、朴根等研究人员领导的研究发表于2025年2月的学术期刊,论文题目为"Extending Language Model Context Up to 3 Million Tokens on a Single GPU"。有兴趣深入了解的读者可以通过arXiv:2502.08910v1访问完整论文。该研究团队还与DeepAuto.ai公司合作,共同开发了这项突破性技术。

现代人工智能就像一个极其聪明但健忘的助手。当你跟它聊天时,它能理解复杂的问题,给出精彩的回答,但有个致命弱点:记不住太多东西。就好比一个人只能记住最近几句话,再往前的内容就会忘得一干二净。这个问题在人工智能领域被称为"上下文长度限制",简单说就是AI的"短期记忆"太小了。

设想你正在与AI讨论一本长篇小说的情节发展,刚开始一切都很顺利,AI能准确理解你提到的人物关系和故事线索。但当对话进行到一定程度后,AI突然开始犯糊涂,忘记了你之前提到的关键情节,甚至搞混了主要角色。这就是当前大型语言模型面临的核心挑战——它们的"记忆容量"严重不足。

传统的解决方案就像给一个书桌很小的学生更多课本一样困难。要么花费巨额资金购买更强大的硬件设备,就像买一张更大的书桌;要么简单粗暴地删除一些旧信息,就像把旧课本扔掉为新书腾地方。这两种方法都有明显缺陷:前者成本高昂,普通人根本用不起;后者会丢失重要信息,影响AI的理解能力。

KAIST的研究团队提出了一个巧妙的解决方案,他们开发的InfiniteHiP系统就像一个精明的图书管理员,能够智能地决定哪些信息需要立即使用,哪些可以暂时存放在"仓库"里。这套系统成功地让单个GPU(图形处理器)就能处理多达300万个词汇的上下文,相比传统方法提升了3倍,同时速度还快了18.95倍。

一、智能筛选:像图书管理员一样管理信息

传统的AI处理长文本时,就像一个强迫症患者必须同时记住每一个细节。当你给它一篇10万字的文档时,它会试图同时关注每一个词汇,这就导致计算量呈几何级数增长。就好比让一个人同时记住一整本字典的每个词条,不仅累得要命,效率也极其低下。

InfiniteHiP采用了一种称为"模块化分层修剪"的技术。这个名字听起来很复杂,但原理其实很简单,就像一个经验丰富的编辑在处理长篇文章时的工作方式。编辑不会逐字逐句地反复阅读整篇文章,而是先快速浏览全文,抓住主要段落;然后在关键段落中找出重要句子;最后聚焦于真正需要仔细推敲的词汇。

具体来说,这套系统分为三个处理阶段。第一个阶段就像用广角镜头扫描整片森林,快速识别出哪些区域最重要。研究团队发现,在一个包含12.8万词汇的文档中,只有不到2%的段落包含了超过12.5%的关键信息,而大约75%的段落根本不包含任何重要信息。这个发现为他们的方法提供了坚实的理论基础。

第二个阶段就像使用望远镜聚焦于重要区域,进一步缩小范围。第三个阶段则像使用放大镜,精确锁定最关键的词汇。通过这种层层递进的方式,系统能够以极高的精度找到真正重要的信息,同时大幅减少需要处理的数据量。

这种方法的巧妙之处在于它的动态性。系统不是预先设定哪些信息重要,而是根据当前的查询内容实时判断。就像一个智能的搜索引擎,当你输入不同的关键词时,它会给出完全不同的搜索结果。这确保了系统始终能够找到与当前对话最相关的信息。

二、记忆拓展:突破预训练长度的枷锁

大多数AI模型都有一个严重局限:它们只能处理与训练时长度相似的文本。这就好比一个只在100米跑道上训练过的运动员,突然被要求跑马拉松,结果可想而知。当模型遇到比训练时更长的文本时,就会出现各种奇怪的问题,理解能力急剧下降。

传统的解决方案是重新训练模型,让它适应更长的文本。但这就像让运动员重新进行长期训练一样,需要大量的时间、数据和计算资源。对于已经部署的模型来说,这种方法既不现实也不经济。

InfiniteHiP团队采用了一种更聪明的策略,称为"动态位置编码调整"。要理解这个概念,我们可以想象AI理解文本时需要给每个词汇分配一个"座位号",就像电影院里的座位一样。传统模型只认识1到1000号座位,当出现1001号座位时就会彻底迷惑。

研究团队的解决方案是让模型学会灵活地重新编排座位号。他们开发了两种策略:一种叫"块索引编码",将相邻的词汇归为一组,给整组分配一个座位号;另一种叫"相对位置编码",不使用绝对的座位号,而是使用相对位置关系,比如"在某个词汇的左边"或"在某个词汇的右边"。

更巧妙的是,系统会根据不同的处理层使用不同的策略。在模型的前几层(相当于初步理解阶段),使用块索引编码来处理位置信息;在后面的层次(相当于深度理解阶段),切换到相对位置编码。这种分层处理方式充分利用了模型不同层次的特点,实现了最佳的长文本处理效果。

三、内存优化:巧用"冷热存储"节省资源

处理超长文本时,另一个重大挑战是内存使用。AI模型在工作时需要将大量信息暂时存储在高速内存中,这些信息被称为"键值缓存"。传统方法就像把所有东西都放在办公桌上一样,桌子很快就会被塞满,无法处理更多内容。

InfiniteHiP采用了一种类似"冷热存储"的策略。就像我们整理文件时,会把经常使用的文件放在手边,把不常用的文件存放到柜子里。系统会智能地判断哪些信息是"热数据"(需要频繁访问),哪些是"冷数据"(暂时不需要但不能删除)。

热数据被保存在GPU的高速内存中,确保快速访问。冷数据则被转移到普通内存中,虽然访问速度稍慢,但节省了宝贵的GPU内存空间。当系统需要使用某个冷数据时,会快速将其调回GPU内存,同时将一些不再需要的热数据降级为冷数据。

这种动态内存管理策略配合了LRU(最近最少使用)策略,类似于我们整理房间时的自然习惯:把最近用过的东西放在容易拿到的地方,把很久没用的东西收起来。这种方法让系统能够用有限的GPU内存处理几乎无限长的文本。

四、性能突破:数字背后的巨大飞跃

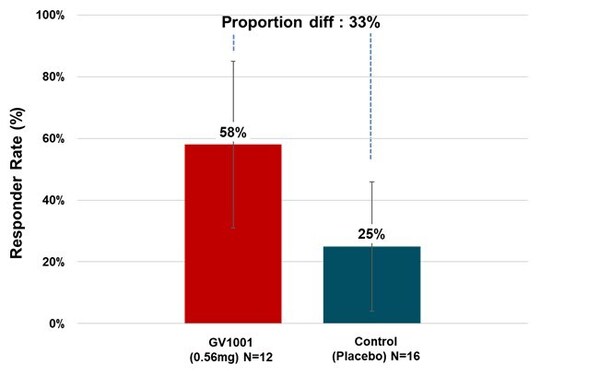

研究团队在多个标准测试中验证了InfiniteHiP的性能。在LongBench测试中,这套系统使用Llama 3模型时比最佳基准方法提高了7.17个百分点,使用Mistral模型时提高了3.19个百分点。更重要的是,系统在处理更长文本时表现更加出色,在∞Bench测试中的提升幅度更加显著。

速度提升更是令人印象深刻。在处理100万词汇的上下文时,预填充阶段的速度提高了20.29倍,解码阶段提高了19.85倍。这意味着原本需要几十分钟才能完成的任务,现在几分钟就能搞定。

内存使用效率的提升同样惊人。在处理25.6万词汇时,传统FlashAttention2方法需要20GB内存,而InfiniteHiP只需要6.1GB,节省了约70%的内存。处理100万词汇时,传统方法需要68GB内存,InfiniteHiP仍然只需要6.1GB,效率提升超过10倍。

研究团队还测试了系统的"记忆准确性"。在一项名为"钥匙找回"的测试中,系统需要在长达100万词汇的文档中准确找到特定信息。InfiniteHiP在各种长度的文档中都保持了98%以上的准确率,证明其不仅快速,而且可靠。

五、实际应用:从理论到现实的距离

为了证明技术的实用性,研究团队将InfiniteHiP集成到了SGLang框架中,这是一个广泛使用的大型语言模型服务平台。集成后的系统能够在单个L40s GPU(拥有48GB内存)上处理300万词汇的上下文,这相当于大约6000页的文档内容。

在真实应用场景中,系统展现了出色的适应性。无论是处理长篇学术论文、分析大型代码库、还是理解复杂的法律文档,InfiniteHiP都能保持稳定的性能。更重要的是,这种技术是"即插即用"的,无需重新训练现有模型,就能显著扩展其处理能力。

研究团队特别测试了系统对不同类型任务的适应能力。在文档问答任务中,系统能够准确理解跨越数万词汇的复杂推理链条。在代码分析任务中,它能够跟踪大型软件项目中的函数调用关系和数据流。在摘要生成任务中,它能够从超长文档中提取核心观点,生成简洁准确的摘要。

六、技术细节:分层处理的精妙设计

InfiniteHiP的核心创新在于其分层处理架构。第一层处理使用较大的数据块,每个块包含256个词汇,快速识别重要区域。这一步的计算复杂度与文档长度成正比,但由于采用了高度并行化的算法,实际处理速度很快。

第二层处理将数据块缩小到32个词汇,在第一层筛选出的重要区域中进行更精细的分析。第三层处理进一步缩小到8个词汇的粒度,最终锁定最关键的信息。每一层都保留前一层选出的最重要部分,确保关键信息不会丢失。

这种设计的巧妙之处在于不同层次之间的协调机制。系统会动态调整每层保留的信息数量,确保在不同长度的文档中都能获得最佳性能。当处理较短文档时,系统会保留更多细节;当处理超长文档时,会更加严格地筛选信息。

缓存策略也经过精心设计。系统不是每次都重新计算注意力模式,而是缓存中间结果,并定期更新。更新频率根据不同层次的特点进行调整:第一层每16步更新一次,第二层每8步更新一次,第三层每4步更新一次。这种差异化的更新策略在保持准确性的同时最大化了计算效率。

七、对比优势:为什么InfiniteHiP脱颖而出

与现有的长文本处理方法相比,InfiniteHiP具有多个显著优势。传统的"滑动窗口"方法虽然能控制计算量,但会丢失历史信息,就像一个只能记住最近几句话的健忘症患者。"注意力稀疏化"方法虽然能保留长期信息,但往往需要预先设定关注模式,缺乏灵活性。

"键值缓存驱逐"策略会永久删除一些信息,当后续对话需要这些信息时就会出问题。而现有的"分层注意力"方法虽然有类似思路,但往往需要多次全局同步,严重影响并行化效率。

InfiniteHiP的独特之处在于它将多种策略有机结合,并且都是在推理时动态进行,不需要修改预训练模型。这种"训练无关"的特性意味着它可以应用到任何现有的大型语言模型上,无需重新训练或微调。

研究团队还特别关注了算法的可扩展性。随着文档长度的增加,系统的性能下降是可控的、可预测的。这与某些方法在超过临界长度后性能急剧下降形成鲜明对比。

八、挑战与局限:技术的边界

尽管InfiniteHiP取得了显著成功,但研究团队诚实地承认了现有技术的局限性。最主要的挑战是预填充阶段仍然需要相当长的时间。即使速度提升了20倍,处理100万词汇的文档仍需要几分钟时间,这在某些实时应用场景中可能不够理想。

另一个挑战是内存使用的线性增长。虽然系统通过冷热存储大幅提高了内存效率,但处理超大文档时仍然受到硬件内存总量的限制。当文档长度达到极限时,即使是普通内存也可能不够用。

系统的性能还依赖于文档的特性。对于信息密度很高、每个部分都同等重要的文档,分层筛选的效果会打折扣。虽然系统仍能正常工作,但性能提升幅度会减少。

研究团队也注意到,不同类型的任务对系统配置有不同要求。处理代码时需要更精细的粒度设置,处理自然语言时则可以使用更大的数据块。目前系统虽然提供了多种预设配置,但仍需要用户根据具体应用场景进行调优。

九、未来展望:技术发展的方向

研究团队对InfiniteHiP的未来发展提出了几个重要方向。首先是进一步优化预填充阶段的速度。他们正在探索"懒加载"和"推测性计算"等技术,希望能够在用户输入文档时就开始预处理,而不是等到完整接收后再开始。

第二个方向是内存压缩技术的集成。通过与量化、压缩等技术结合,有望进一步降低内存使用,处理更长的文档。研究团队特别看好"渐进式压缩"的思路,即根据信息的重要性采用不同程度的压缩。

第三个方向是自适应配置技术。未来的系统应该能够自动分析文档特征,选择最合适的处理策略,而不需要用户手动调优。这需要结合机器学习技术,让系统从大量实例中学习最佳配置模式。

研究团队还在探索将InfiniteHiP扩展到多模态场景,处理包含文本、图像、音频等多种信息的长序列。这对自动驾驶、机器人控制等应用领域具有重要意义。

十、影响与意义:改变AI应用的可能性

InfiniteHiP技术的意义远超出了技术本身。它为AI应用开启了许多以前无法实现的可能性。在教育领域,AI助手现在可以分析整本教科书,为学生提供跨章节的深度解答。在法律领域,AI可以同时参考大量相关案例和法规,提供更全面的法律建议。

在科研领域,研究人员可以让AI分析整个研究领域的文献,发现跨论文的研究模式和趋势。在软件开发中,AI可以理解整个代码库的结构,提供更准确的代码建议和错误诊断。

这项技术也让AI的"个性化"成为可能。通过分析用户的完整对话历史,AI可以更好地理解用户的偏好和需求,提供更加贴心的服务。这种"长期记忆"能力让AI与用户的交互更加自然和连贯。

从商业角度看,InfiniteHiP显著降低了部署长文本AI应用的成本。原本需要昂贵的多GPU集群才能处理的任务,现在用一块消费级GPU就能完成。这让更多的中小企业和个人开发者能够享受到先进AI技术的红利。

说到底,InfiniteHiP解决的不仅仅是技术问题,更是让AI真正具备了处理复杂、长篇内容的能力。就像给一个聪明但健忘的助手配备了完美的记忆系统,现在它不仅能理解复杂问题,还能记住完整的上下文,为用户提供更加智能和贴心的帮助。这项技术的普及将推动AI应用进入一个全新的阶段,让人工智能真正成为我们处理复杂信息的得力助手。KAIST团队的这项突破为整个AI领域指明了一个重要的发展方向,相信会激发更多创新研究,推动长文本AI技术的快速发展。

Q&A

Q1:InfiniteHiP是什么?它能做什么?

A:InfiniteHiP是由韩国科学技术院开发的长文本AI处理系统,它能让单个GPU处理多达300万个词汇的超长文档,相当于6000页的内容。这套系统就像一个智能图书管理员,能够快速找到长文档中的关键信息,速度比传统方法快18倍,内存使用却减少70%。

Q2:InfiniteHiP和现有的AI模型有什么区别?

A:最大的区别是InfiniteHiP不需要重新训练AI模型就能大幅扩展其记忆能力。传统AI模型就像只能记住几句话的健忘症患者,而InfiniteHiP通过智能的信息筛选和内存管理技术,让AI能够同时处理和理解超长文档,且是即插即用的。

Q3:普通用户什么时候能用上InfiniteHiP技术?

A:研究团队已经将InfiniteHiP集成到SGLang框架中,这是一个开源的AI服务平台。由于这是"训练无关"技术,理论上可以应用到任何现有的大型语言模型上。不过从研究成果到消费级产品还需要一定时间,预计未来1-2年内会有商业化应用出现。

更新内容

一、修复bug,修改自动播放;优化产品用户体验。

二、 1.修复已知Bug。2.新服务。

三、修复已知bug;优化用户体验

四、1,交互全面优化,用户操作更加便捷高效;2,主题色更新,界面风格更加协调;3,增加卡片类个人数据

五、-千万商品随意挑选,大图展现商品细节-订单和物流查询实时同步-支持团购和名品特卖,更有手机专享等你抢-支付宝和银联多种支付方式,轻松下单,快捷支付-新浪微博,支付宝,QQ登录,不用注册也能购物-支持商品收藏,随时查询喜爱的商品和历史购物清单。

六、1.bug修复,提升用户体验;2.优化加载,体验更流程;3.提升安卓系统兼容性

七、1、修复部分机型bug;2、提高游戏流畅度;

厂商其他下载

安卓应用 安卓手游 苹果应用 苹果手游 电脑 更多+

-

闫桉撒娇便宜了2毛钱

闫桉撒娇便宜了2毛钱

-

台湾宜兰县发生4.9级地震

台湾宜兰县发生4.9级地震

-

樊振东用德语打招呼

樊振东用德语打招呼

-

iPhone 17系列新品前瞻

iPhone 17系列新品前瞻

-

梓渝田栩宁展轩刘轩丞都有工作室了

梓渝田栩宁展轩刘轩丞都有工作室了

-

整条船上的人瞬间命苦了起来

整条船上的人瞬间命苦了起来

-

高卿尘粤语基础肢体就不基础

高卿尘粤语基础肢体就不基础

-

敖子逸的敖是敖隐的敖

敖子逸的敖是敖隐的敖

-

王影璐新剧找回记忆

王影璐新剧找回记忆

-

杨志刚为唐朝诡事录之长安配音

杨志刚为唐朝诡事录之长安配音

-

孟子义夸丁程鑫是个好演员

孟子义夸丁程鑫是个好演员

-

鹭卓体验了一把新发型

鹭卓体验了一把新发型

-

这是我最能get到李现的时候

这是我最能get到李现的时候

-

陈乔恩谈这辈子最勇敢的事

陈乔恩谈这辈子最勇敢的事

-

农民工老姚获奖了

农民工老姚获奖了

-

马伯骞手打戒指狂省1000块

马伯骞手打戒指狂省1000块

-

疑似何穗退圈

疑似何穗退圈

-

双刀切面包挑战

双刀切面包挑战

-

四川人民都接到通知了吗

四川人民都接到通知了吗

-

最省成本的短剧出现了

最省成本的短剧出现了

相关版本

- 中文名:KAIST团队让大模型记忆力暴涨3倍的神奇方法

- 包名:com.ejiaqrp.dtgen

- MD5:P7ENQIWOC1RTO1T6EP

查看所有 0条评论>网友评论

- 相关游戏

-

00后两男生开房住宿留下满床辣条油

00后两男生开房住宿留下满床辣条油

专家:A股牛市正在加速

专家:A股牛市正在加速

当军训遇到网红教官

当军训遇到网红教官

博主傅永琪去英国留学

博主傅永琪去英国留学

台湾民众应该怎么看九三阅兵

台湾民众应该怎么看九三阅兵

孙良轩再次闯关快乐向前冲

孙良轩再次闯关快乐向前冲

邱毅:“大罢免”戳破假象

邱毅:“大罢免”戳破假象

93秒预习九三大阅兵

93秒预习九三大阅兵

苹果版本更新主要变化

苹果版本更新主要变化

女子2岁发病双脚萎缩像橡胶

女子2岁发病双脚萎缩像橡胶

特朗普释放访华诚意有何目的

特朗普释放访华诚意有何目的

干饭的星辰 gogogo出发领奖喽

干饭的星辰 gogogo出发领奖喽

宋威龙张婧仪七夕直播

宋威龙张婧仪七夕直播

沃尔沃全新XC70预售价29.99万起

沃尔沃全新XC70预售价29.99万起

毛豆走了带着满满的脱口秀素材

毛豆走了带着满满的脱口秀素材

樊振东回应是否重返国乒

樊振东回应是否重返国乒

丈夫两次冲进火场救妻双双烧伤

丈夫两次冲进火场救妻双双烧伤

iPhone17全系价格曝光

iPhone17全系价格曝光

中国第一个“三机场”城市来了

中国第一个“三机场”城市来了

王霏霏孟佳超级夏晚合体

王霏霏孟佳超级夏晚合体

歌手韩磊回应被曝致女生怀孕:已报警

歌手韩磊回应被曝致女生怀孕:已报警

郑佩佩儿媳乳腺癌恶化

郑佩佩儿媳乳腺癌恶化

徐州医科大学校长郑骏年被查

徐州医科大学校长郑骏年被查

我能看懂的英语能是什么好英语

我能看懂的英语能是什么好英语

台湾是中国领土不可分割的一部分

台湾是中国领土不可分割的一部分

霉霉订婚细节曝光

霉霉订婚细节曝光

有一种治愈叫看大熊猫睡觉

有一种治愈叫看大熊猫睡觉

iPhone 17全系价格曝光

iPhone 17全系价格曝光

倪虹洁新剧三任前夫糟心图鉴

倪虹洁新剧三任前夫糟心图鉴

天津发布暴雨蓝色预警

天津发布暴雨蓝色预警

打工人的体味为啥越来越重了

打工人的体味为啥越来越重了

小高我是奶龙

小高我是奶龙

何运晨密室行为艺术大乱炖

何运晨密室行为艺术大乱炖

颜安刀马刀马像走进了舒适区

颜安刀马刀马像走进了舒适区

大表哥神秘天坑抓鱼

大表哥神秘天坑抓鱼

黄渤直播被粉丝和员工整没招了

黄渤直播被粉丝和员工整没招了

田曦薇许凯新剧大婚夜浴桶吻

田曦薇许凯新剧大婚夜浴桶吻

鞠婧祎直播

鞠婧祎直播

王星越刀马刀马就登上武功山

王星越刀马刀马就登上武功山

7月份制造业利润同比增长6.8%

7月份制造业利润同比增长6.8%

- 更多>心动网络手游

-

执法地现场调查小区隐藏豪华建筑

执法地现场调查小区隐藏豪华建筑

疑似何穗退圈

疑似何穗退圈

郑恺回应停掉岳母亲属卡

郑恺回应停掉岳母亲属卡

樊振东德语首秀

樊振东德语首秀

赵丽颖曾让保镖一起撑伞躲雨

赵丽颖曾让保镖一起撑伞躲雨

2024T1冠军皮肤

2024T1冠军皮肤

和爱的人二次初恋是什么感受

和爱的人二次初恋是什么感受

周深音乐里科技无法取代的部分

周深音乐里科技无法取代的部分

与晋长安好看吗

与晋长安好看吗

王影璐新剧找回记忆

王影璐新剧找回记忆

未来三天山西雨水频繁

未来三天山西雨水频繁

iPhone17全系价格曝光

iPhone17全系价格曝光

徐艺洋BubbleGum好丝滑

徐艺洋BubbleGum好丝滑

女子洗头没吹干骑车上班被风吹面瘫

女子洗头没吹干骑车上班被风吹面瘫

中国女排争夺小组第一

中国女排争夺小组第一

子夜归一家三口 好嗑

子夜归一家三口 好嗑

发的馒头被质疑不卫生?川航回应

发的馒头被质疑不卫生?川航回应

男子空腹喝特浓咖啡突发心悸

男子空腹喝特浓咖啡突发心悸

宋亚轩 敬山水

宋亚轩 敬山水

四川人民都接到通知了吗

四川人民都接到通知了吗

何穗 陈伟霆

何穗 陈伟霆

宋威龙陈异

宋威龙陈异

中国女排小组第一进16强

中国女排小组第一进16强

田曦薇的猫 好大一辆卡车

田曦薇的猫 好大一辆卡车

网红白冰三个月瘦了50斤

网红白冰三个月瘦了50斤

班子三人半个月内相继落马

班子三人半个月内相继落马

张碧晨要去超级夏晚唱歌了

张碧晨要去超级夏晚唱歌了

子夜归表哥下线

子夜归表哥下线

杨颖和粉丝道别快哭了

杨颖和粉丝道别快哭了

龚俊演我开小差被抓

龚俊演我开小差被抓

暑假能再放一遍吗很多细节没看清

暑假能再放一遍吗很多细节没看清

人 想喝蜜鼠冰城吗

人 想喝蜜鼠冰城吗

孟子义何与差点就亲上了

孟子义何与差点就亲上了

幻梦都破碎是什么梗

幻梦都破碎是什么梗

刘涛真的有在偷偷补网梗

刘涛真的有在偷偷补网梗

如果你在我20岁之前认识我

如果你在我20岁之前认识我

异形宝宝破肺而出 万字拆解EP04

异形宝宝破肺而出 万字拆解EP04

虞书欣与其父不存在直接商业关联

虞书欣与其父不存在直接商业关联

杨颖和粉丝道别快哭了

杨颖和粉丝道别快哭了

台湾是中国领土不可分割的一部分

台湾是中国领土不可分割的一部分

- 更多>mod游戏

-

台退将:日本不要忘记中国已经强大

台退将:日本不要忘记中国已经强大

耐心都留给了好朋友

耐心都留给了好朋友

这是你没见过的阅兵训练画面

这是你没见过的阅兵训练画面

印度暴雨过后 鳄鱼在马路上散步

印度暴雨过后 鳄鱼在马路上散步

辽宁文旅又来整活了

辽宁文旅又来整活了

张伦硕报警

张伦硕报警

龚俊亲吻鲨鱼挑战

龚俊亲吻鲨鱼挑战

美团将于年底全面取消超时扣款

美团将于年底全面取消超时扣款

22岁女村支书离世后父亲发声

22岁女村支书离世后父亲发声

听到理想型开学就睁眼

听到理想型开学就睁眼

星舰溅落印度洋结束第十次试飞

星舰溅落印度洋结束第十次试飞

大鑫 送自己一个奖杯吧

大鑫 送自己一个奖杯吧

伯远在线教学粤语

伯远在线教学粤语

印度一猴子站树上向人群狂撒8万卢比

印度一猴子站树上向人群狂撒8万卢比

小小年纪就能体会到人心险恶

小小年纪就能体会到人心险恶

白鹿看不腻live图

白鹿看不腻live图

向太陈岚入驻快手

向太陈岚入驻快手

阿勒泰云海漫卷梦幻感具象化了

阿勒泰云海漫卷梦幻感具象化了

田曦薇的猫 好大一辆卡车

田曦薇的猫 好大一辆卡车

当我用做酸奶碗的方式化妆

当我用做酸奶碗的方式化妆

黄晓明你的303回来了

黄晓明你的303回来了

22岁女村支书离世后父亲发声

22岁女村支书离世后父亲发声

简单动作缓解久坐不适

简单动作缓解久坐不适

目之所及全员疯批

目之所及全员疯批

志极

志极

日本试图干涉九三阅兵在怕什么

日本试图干涉九三阅兵在怕什么

毛豆走了带着满满的脱口秀素材

毛豆走了带着满满的脱口秀素材

崩铁刻律德菈综合测评

崩铁刻律德菈综合测评

员工查出血管瘤要求不上夜班遭解雇

员工查出血管瘤要求不上夜班遭解雇

李云龙秀芹是多少人的意难平

李云龙秀芹是多少人的意难平

歌手韩磊回应被曝致女生怀孕:已报警

歌手韩磊回应被曝致女生怀孕:已报警

平台标价过夜伴游8000一次

平台标价过夜伴游8000一次

找不到这段吻戏的退出键

找不到这段吻戏的退出键

中国拖船进入南海意味着什么

中国拖船进入南海意味着什么

网警守护开学季

网警守护开学季

当时代少年团住在同一所公寓

当时代少年团住在同一所公寓

好极了明星团七夕组局玩浪漫

好极了明星团七夕组局玩浪漫

金牌志虎最佳男主角

金牌志虎最佳男主角

专家谈歼20S或亮相九三阅兵

专家谈歼20S或亮相九三阅兵

农村小博卿收到领奖邀请

农村小博卿收到领奖邀请

- 更多>像素rpg游戏

-

电影狄仁杰之降魔咒上线

电影狄仁杰之降魔咒上线

樊振东祝福霉霉订婚

樊振东祝福霉霉订婚

被指出轨致女生怀孕 韩磊方报警

被指出轨致女生怀孕 韩磊方报警

班子三人半个月内相继落马

班子三人半个月内相继落马

农民工老姚获奖了

农民工老姚获奖了

金冬天挑染造型

金冬天挑染造型

女儿回应父亲失踪9年后突然回家

女儿回应父亲失踪9年后突然回家

老人落水民警一路狂奔跳水救人

老人落水民警一路狂奔跳水救人

13岁男孩患8种绝症写信求妈妈弃疗

13岁男孩患8种绝症写信求妈妈弃疗

胡先煦天津门面

胡先煦天津门面

小美满开播

小美满开播

日本试图干涉九三阅兵是在怕什么

日本试图干涉九三阅兵是在怕什么

网友称韩磊致其怀孕

网友称韩磊致其怀孕

当我用做酸奶碗的方式化妆

当我用做酸奶碗的方式化妆

少司缘大司命狐妖皮肤返场

少司缘大司命狐妖皮肤返场

樊振东祝福霉霉订婚

樊振东祝福霉霉订婚

孟子义何与差点就亲上了

孟子义何与差点就亲上了

燕云十六声新地图即将上线

燕云十六声新地图即将上线

两只小奶狗被人恶意绑住双脚和嘴巴

两只小奶狗被人恶意绑住双脚和嘴巴

女子悬赏上海1套房寻被拐儿子

女子悬赏上海1套房寻被拐儿子

霉霉订婚

霉霉订婚

虞书欣起诉两公司侵权

虞书欣起诉两公司侵权

中央气象台4预警齐发

中央气象台4预警齐发

曝刘书宏席惟伦约会

曝刘书宏席惟伦约会

当我用身体波浪回答问题

当我用身体波浪回答问题

把装修师傅约在同一天belike

把装修师傅约在同一天belike

七夕前的奶茶店

七夕前的奶茶店

倪虹洁新剧离婚三次

倪虹洁新剧离婚三次

樊振东你担订婚了

樊振东你担订婚了

被海鲜扎伤千万别大意

被海鲜扎伤千万别大意

特朗普祝福霉霉

特朗普祝福霉霉

张予曦又美出新高度

张予曦又美出新高度

登陆少年向你发起关于幸福的邀约

登陆少年向你发起关于幸福的邀约

多多佳鑫

多多佳鑫

听到理想型开学就睁眼

听到理想型开学就睁眼

刘宇微微辣震感好强

刘宇微微辣震感好强

少司缘大司命狐妖皮肤返场

少司缘大司命狐妖皮肤返场

无限暖暖星露谷物语联动

无限暖暖星露谷物语联动

中国主要山脉的背诵口诀

中国主要山脉的背诵口诀

WE零封AL

WE零封AL

-

2025-08-28

1

-

2025-08-28

2

-

2025-08-28

3

-

2025-08-28

4

-

2025-08-28

5

-

2025-08-28

6

-

2025-08-28

7

-

2025-08-28

8

-

2025-08-28

9

-

2025-08-28

10

-

2025-08-28

11

-

2025-08-28

12

-

2025-08-28

13

-

2025-08-28

14

-

2025-08-28

15

-

2025-08-28

16

-

2025-08-28

17

-

2025-08-28

18

-

2025-08-28

19

-

2025-08-28

20

-

2025-08-28

21

-

2025-08-28

22

-

2025-08-28

23

-

2025-08-28

24

-

2025-08-28

25

-

2025-08-28

26

-

2025-08-28

27

-

2025-08-28

28

-

2025-08-28

29

-

2025-08-28

30

-

2025-08-28

31

-

2025-08-28

32

-

2025-08-28

33

-

2025-08-28

34

-

2025-08-28

35

-

2025-08-28

36

-

2025-08-28

37

-

2025-08-28

38

-

2025-08-28

39

-

2025-08-28

40

-

2025-08-28

41

-

2025-08-28

42

-

2025-08-28

43

-

2025-08-28

44

-

2025-08-28

45

-

2025-08-28

46

-

2025-08-28

47

-

2025-08-28

48

-

2025-08-28

49

-

2025-08-28

50

-

2025-08-28

51

-

2025-08-28

52

-

2025-08-28

53

-

2025-08-28

54

-

2025-08-28

55

-

2025-08-28

56

-

2025-08-28

57

-

2025-08-28

58

-

2025-08-28

59

-

2025-08-28

60

-

2025-08-28

61

-

2025-08-28

62

-

2025-08-28

63

-

2025-08-28

64

-

2025-08-28

65

-

2025-08-28

66

-

2025-08-28

67

-

2025-08-28

68

-

2025-08-28

69

-

2025-08-28

70

-

2025-08-28

71

-

2025-08-28

72

-

2025-08-28

73

-

2025-08-28

74

-

2025-08-28

75

-

2025-08-28

76

-

2025-08-28

77

-

2025-08-28

78

-

2025-08-28

79

-

2025-08-28

80

-

2025-08-28

81

-

2025-08-28

82

-

2025-08-28

83

-

2025-08-28

84

-

2025-08-28

85

-

2025-08-28

86

-

2025-08-28

87

-

2025-08-28

88

-

2025-08-28

89

-

2025-08-28

90

-

2025-08-28

91

-

2025-08-28

92

-

2025-08-28

93

-

2025-08-28

94

-

2025-08-28

95

-

2025-08-28

96

-

2025-08-28

97

-

2025-08-28

98

-

2025-08-28

99

-

2025-08-28

100

-

2025-08-28

101

-

2025-08-28

102

-

2025-08-28

103

-

2025-08-28

104

-

2025-08-28

105

-

2025-08-28

106

-

2025-08-28

107

-

2025-08-28

108

-

2025-08-28

109

-

2025-08-28

110

-

2025-08-28

111

-

2025-08-28

112

-

2025-08-28

113

-

2025-08-28

114

-

2025-08-28

115

-

2025-08-28

116

-

2025-08-28

117

-

2025-08-28

118

-

2025-08-28

119

-

2025-08-28

120

-

2025-08-28

121

-

2025-08-28

122

-

2025-08-28

123

-

2025-08-28

124

-

2025-08-28

125

-

2025-08-28

126

-

2025-08-28

127

-

2025-08-28

128

-

2025-08-28

129

-

2025-08-28

130

-

2025-08-28

131

-

2025-08-28

132

-

2025-08-28

133

-

2025-08-28

134

-

2025-08-28

135

-

2025-08-28

136

-

2025-08-28

137

-

2025-08-28

138

-

2025-08-28

139

-

2025-08-28

140

-

2025-08-28

141

-

2025-08-28

142

-

2025-08-28

143

-

2025-08-28

144

-

2025-08-28

145

-

2025-08-28

146

-

2025-08-28

147

-

2025-08-28

148

-

2025-08-28

149

-

2025-08-28

150

-

2025-08-28

151

-

2025-08-28

152

-

2025-08-28

153

-

2025-08-28

154

-

2025-08-28

155

-

2025-08-28

156

-

2025-08-28

157

-

2025-08-28

158

-

2025-08-28

159

-

2025-08-28

160

-

2025-08-28

161

-

2025-08-28

162

-

2025-08-28

163

-

2025-08-28

164

-

2025-08-28

165

-

2025-08-28

166

-

2025-08-28

167

-

2025-08-28

168

-

2025-08-28

169

-

2025-08-28

170

-

2025-08-28

171

-

2025-08-28

172

-

2025-08-28

173

-

2025-08-28

174

-

2025-08-28

175

-

2025-08-28

176

-

2025-08-28

177

-

2025-08-28

178

-

2025-08-28

179

-

2025-08-28

180

-

2025-08-28

181

-

2025-08-28

182

-

2025-08-28

183

-

2025-08-28

184

-

2025-08-28

185

-

2025-08-28

186

-

2025-08-28

187

-

2025-08-28

188

-

2025-08-28

189

-

2025-08-28

190

-

2025-08-28

191

-

2025-08-28

192

-

2025-08-28

193

-

2025-08-28

194

-

2025-08-28

195

-

2025-08-28

196

-

2025-08-28

197

-

2025-08-28

198

-

2025-08-28

199

-

2025-08-28

200

-

2025-08-28

201

-

2025-08-28

202

-

2025-08-28

203

-

2025-08-28

204

-

2025-08-28

205

-

2025-08-28

206

-

2025-08-28

207

-

2025-08-28

208

-

2025-08-28

209

-

2025-08-28

210

-

2025-08-28

211

-

2025-08-28

212

-

2025-08-28

213

-

2025-08-28

214

-

2025-08-28

215

-

2025-08-28

216

-

2025-08-28

217

-

2025-08-28

218

-

2025-08-28

219

-

2025-08-28

220

-

2025-08-28

221

-

2025-08-28

222

-

2025-08-28

223

-

2025-08-28

224

-

2025-08-28

225

-

2025-08-28

226

-

2025-08-28

227

-

2025-08-28

228

-

2025-08-28

229

-

2025-08-28

230

-

2025-08-28

231

-

2025-08-28

232

-

2025-08-28

233

-

2025-08-28

234

-

2025-08-28

235

-

2025-08-28

236

-

2025-08-28

237

-

2025-08-28

238

-

2025-08-28

239

-

2025-08-28

240

-

2025-08-28

241

-

2025-08-28

242

-

2025-08-28

243

-

2025-08-28

244

-

2025-08-28

245

-

2025-08-28

246

-

2025-08-28

247

-

2025-08-28

248

-

2025-08-28

249

-

2025-08-28

250

-

2025-08-28

251

-

2025-08-28

252

-

2025-08-28

253

-

2025-08-28

254

-

2025-08-28

255

-

2025-08-28

256

-

2025-08-28

257

-

2025-08-28

258

-

2025-08-28

259

-

2025-08-28

260

-

2025-08-28

261

-

2025-08-28

262

-

2025-08-28

263

-

2025-08-28

264

-

2025-08-28

265

-

2025-08-28

266

-

2025-08-28

267

-

2025-08-28

268

-

2025-08-28

269

-

2025-08-28

270

-

2025-08-28

271

-

2025-08-28

272

-

2025-08-28

273

-

2025-08-28

274

-

2025-08-28

275

-

2025-08-28

276

-

2025-08-28

277

-

2025-08-28

278

-

2025-08-28

279

-

2025-08-28

280

-

2025-08-28

281

-

2025-08-28

282

-

2025-08-28

283

-

2025-08-28

284

-

2025-08-28

285

-

2025-08-28

286

-

2025-08-28

287

-

2025-08-28

288

-

2025-08-28

289

-

2025-08-28

290

-

2025-08-28

291

-

2025-08-28

292

-

2025-08-28

293

-

2025-08-28

294

-

2025-08-28

295

-

2025-08-28

296

-

2025-08-28

297

-

2025-08-28

298

-

2025-08-28

299

-

2025-08-28

300

-

2025-08-28

301

-

2025-08-28

302

-

2025-08-28

303

-

2025-08-28

304

-

2025-08-28

305

-

2025-08-28

306

-

2025-08-28

307

-

2025-08-28

308

-

2025-08-28

309

-

2025-08-28

310

-

2025-08-28

311

-

2025-08-28

312

-

2025-08-28

313

-

2025-08-28

314

-

2025-08-28

315

-

2025-08-28

316

-

2025-08-28

317

-

2025-08-28

318

-

2025-08-28

319

-

2025-08-28

320

-

2025-08-28

321

-

2025-08-28

322

-

2025-08-28

323

-

2025-08-28

324

-

2025-08-28

325

-

2025-08-28

326

-

2025-08-28

327

-

2025-08-28

328

-

2025-08-28

329

-

2025-08-28

330

-

2025-08-28

331

-

2025-08-28

332

-

2025-08-28

333

-

2025-08-28

334

-

2025-08-28

335

-

2025-08-28

336

-

2025-08-28

337

-

2025-08-28

338

-

2025-08-28

339

-

2025-08-28

340

-

2025-08-28

341

-

2025-08-28

342

-

2025-08-28

343

-

2025-08-28

344

-

2025-08-28

345

-

2025-08-28

346

-

2025-08-28

347

-

2025-08-28

348

-

2025-08-28

349

-

2025-08-28

350

-

2025-08-28

351

-

2025-08-28

352

-

2025-08-28

353

-

2025-08-28

354

-

2025-08-28

355

-

2025-08-28

356

-

2025-08-28

357

-

2025-08-28

358

-

2025-08-28

359

-

2025-08-28

360

-

2025-08-28

361

-

2025-08-28

362

-

2025-08-28

363

-

2025-08-28

364

-

2025-08-28

365

-

2025-08-28

366

-

2025-08-28

367

-

2025-08-28

368

-

2025-08-28

369

-

2025-08-28

370

-

2025-08-28

371

-

2025-08-28

372

-

2025-08-28

373

-

2025-08-28

374

-

2025-08-28

375

-

2025-08-28

376

-

2025-08-28

377

-

2025-08-28

378

-

2025-08-28

379

-

2025-08-28

380

-

2025-08-28

381

-

2025-08-28

382

-

2025-08-28

383

-

2025-08-28

384

-

2025-08-28

385

-

2025-08-28

386

-

2025-08-28

387

-

2025-08-28

388

-

2025-08-28

389

-

2025-08-28

390

-

2025-08-28

391

-

2025-08-28

392

-

2025-08-28

393

-

2025-08-28

394

-

2025-08-28

395

-

2025-08-28

396

-

2025-08-28

397

-

2025-08-28

398

-

2025-08-28

399

-

2025-08-28

400

-

2025-08-28

1

-

2025-08-28

2

-

2025-08-28

3

-

2025-08-28

4

-

2025-08-28

5

-

2025-08-28

6

-

2025-08-28

7

-

2025-08-28

8

-

2025-08-28

9

-

2025-08-28

10

-

2025-08-28

11

-

2025-08-28

12

-

2025-08-28

13

-

2025-08-28

14

-

2025-08-28

15

-

2025-08-28

16

-

2025-08-28

17

-

2025-08-28

18

-

2025-08-28

19

-

2025-08-28

20

-

2025-08-28

21

-

2025-08-28

22

-

2025-08-28

23

-

2025-08-28

24

-

2025-08-28

25

-

2025-08-28

26

-

2025-08-28

27

-

2025-08-28

28

-

2025-08-28

29

-

2025-08-28

30

-

2025-08-28

31

-

2025-08-28

32

-

2025-08-28

33

-

2025-08-28

34

-

2025-08-28

35

-

2025-08-28

36

-

2025-08-28

37

-

2025-08-28

38

-

2025-08-28

39

-

2025-08-28

40

-

2025-08-28

41

-

2025-08-28

42

-

2025-08-28

43

-

2025-08-28

44

-

2025-08-28

45

-

2025-08-28

46

-

2025-08-28

47

-

2025-08-28

48

-

2025-08-28

49

-

2025-08-28

50

-

2025-08-28

51

-

2025-08-28

52

-

2025-08-28

53

-

2025-08-28

54

-

2025-08-28

55

-

2025-08-28

56

-

2025-08-28

57

-

2025-08-28

58

-

2025-08-28

59

-

2025-08-28

60

-

2025-08-28

61

-

2025-08-28

62

-

2025-08-28

63

-

2025-08-28

64

-

2025-08-28

65

-

2025-08-28

66

-

2025-08-28

67

-

2025-08-28

68

-

2025-08-28

69

-

2025-08-28

70

-

2025-08-28

71

-

2025-08-28

72

-

2025-08-28

73

-

2025-08-28

74

-

2025-08-28

75

-

2025-08-28

76

-

2025-08-28

77

-

2025-08-28

78

-

2025-08-28

79

-

2025-08-28

80

-

2025-08-28

81

-

2025-08-28

82

-

2025-08-28

83

-

2025-08-28

84

-

2025-08-28

85

-

2025-08-28

86

-

2025-08-28

87

-

2025-08-28

88

-

2025-08-28

89

-

2025-08-28

90

-

2025-08-28

91

-

2025-08-28

92

-

2025-08-28

93

-

2025-08-28

94

-

2025-08-28

95

-

2025-08-28

96

-

2025-08-28

97

-

2025-08-28

98

-

2025-08-28

99

-

2025-08-28

100